En el más amplio sentido de la palabra, la fiabilidad de un sistema se asocia con el funcionamiento correcto y la ausencia de averías y fallos. Sin embargo, desde el punto de vista de la ingeniería, debe definirse cuantitativamente como una probabilidad. Así, se define la fiabilidad como la probabilidad de que un sistema cumpla las funciones para las que fue diseñado, bajo unas especificaciones dadas y durante un periodo determinado.

Se definen distintos tipos de fiabilidad:

- Fiabilidad especificada: Valor de fiabilidad que debe alcanzar el equipo.

- Fiabilidad inherente: Valor de fiabilidad resultante de la concepción del proyecto, sin que intervenga la degradación que normalmente producirá la fabricación del sistema y de sus componentes.

- Fiabilidad estimada o prevista: Es el valor obtenido a partir de datos históricos con determinado nivel de confianza.

- Fiabilidad demostrada: Es el valor de fiabilidad obtenido por medición de una serie unidades, con un determinado nivel de confianza.

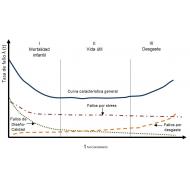

En general, la distribución de los distintos tipos de fallos (fig.1) que se presentan a lo largo de la vida de una población de un determinado equipo, se combinan para dar como resultado la conocida “curva de bañera”, que divide convencionalmente la vida del equipo en fase de mortalidad infantil, fase de vida útil y fase de desgaste.

Los fallos provocados por defecto de diseño y de calidad, tienen normalmente una fuerte pendiente decreciente y dominan la fase de mortalidad infantil. La fase de vida útil de los equipos electrónicos maduros, se caracteriza por una tasa de fallo pequeña y constante, que sigue aproximadamente una ley de distribución exponencial y está gobernada por los defectos intrínsecos relacionados con los stress electricos, térmicos, etc. que se producen de forma aleatoria. Finalmente, en la etapa de desgaste, pueden producirse fallos provocados por el agotamiento de los componentes.

El objetivo del programa de fiabilidad es garantizar que la etapa de mortalidad infantil sea corta y que el periodo de vida útil sea largo y con una tasa de fallo estabilizada en un nivel bajo. Para ello, durante la fase de diseño y desarrollo y en la posterior industrialización, deben tomarse medidas que evalúen el impacto de los defectos intrínsecos y de aquéllos inducidos por el proceso de fabricación, que garanticen la eficiencia de las inspecciones convencionales y la efectividad de los test de filtrado (reliability screening tests) que se apliquen. En concreto, las etapas de un programa de fiabilidad son:

- Diseño de alto nivel

- Predicción inicial de la fiabilidad

- Asignación de la fiabilidad

- AMFE

- Análisis térmico

- Análisis de tolerancias

- Derating de los componentes

- Predicción final de la fiabilidad

- ESS – Environmental Stress Screening

- Demostración de la fiabilidad

PREDICCIÓN INICIAL DE LA FIABILIDAD

El objetivo de la predicción de la fiabilidad es estimar la tasa de fallo que tendrá un equipo en su fase de uso, con objeto de que el diseñador pueda valorar la capacidad de su diseño para cumplir con el requisito de fiabilidad especificada y pueda identificar los bloques de diseño que requieran aplicar un esfuerzo especial.

La mayoría de los modelos de predicción de la fiabilidad se apoyan en bases de datos empíricas y están sometidos a dos fuentes de variabilidad:

- Las estimaciones usadas son promedios y no tienen en cuenta ni varianzas, ni intervalos de confianza.

- Los promedios empleados como estimaciones, se basan en productos fabricados en el pasado, por lo que las mejoras posteriores que se hayan producido en la fiabilidad de los componentes no se reflejarán. Para solucionar el problema, el ingeniero de fiabilidad aplicará a veces factores correctores que tengan en cuenta la mejora de fiabilidad conseguida en el tiempo por la madurez de las tecnologías.

Por tanto, al analizar la tasa de fallo prevista para un producto y compararlo con otros, debemos asegurarnos de que el modelo de predicción de la fiabilidad empleado es el mismo en ambos casos y de que se han empleado los mismos factores correctores.

Además, no debe perderse de vista, que el resultado de la predicción es la fiabilidad inherente del driver, que es la resultante de la concepción del proyecto. No tiene en cuenta ni los defectos de las materias primas, ni la degradación en la fiabilidad que producirá la fabricación de la unidad, ni la que pueda provocar una instalación en condiciones distintas a las previstas.

Los modelos de predicción de fiabilidad asumen que la distribución de probabilidad de fallo que siguen los componentes y equipos electrónicos es exponencial, con una tasa de fallos constante λ. Por tanto son válidos sólo para estimar la fiabilidad en la etapa de vida útil de la curva de bañera, en la que la tasa de fallo permanece constante. Por tanto, la función fiabilidad o probabilidad de que el equipo sobreviva hasta un determinado instante t será:

La distribución exponencial tiene dos propiedades destacadas de gran importancia en fiabilidad:

- “No tiene memoria”, es decir: la probabilidad de que un equipo falle durante un periodo futuro es independiente de la edad que tenga el equipo.

- La tasa de fallo de equipos en serie, es la suma de las tasas de fallo de cada uno de ellos.

Un driver de corriente constante para alumbrado exterior LED, constituye un sistema serie porque si un componente falla, puede considerarse que ha fallado el sistema. La probabilidad de que sobreviva un sistema serie es igual al producto de las probabilidades de supervivencia de cada componente en serie, asumiendo un funcionamiento independiente, donde la tasa de fallo del sistema driver, es la suma de las tasas de fallo de los componentes que lo integran. Y para equipos no reparables, el tiempo medio hasta el fallo es la inversa de la tasa de fallo del equipo.

En esta fase incial del desarrollo del driver, la predicción de la fiabilidad se realiza empleando el modelo de conteo de componentes (Part Count) expuesto en el apéndice A del MIL-HDBK-217F(N2) [2]. En él, la tasa de fallo del driver, λsistema, se calcula como se ha expuesto anteriormente, pero introduciendo un factor de calidad πQ, que prima los componentes que cumplen las normas militares del Departamento de Defensa de los Estados Unidos y cuyos valores van de 0,01 para un componente sometido a todos los screening test especificados por dichas normas militares, a 10 para un componente comercial. Por tanto:

siendo:

n: número de familias genéricas de componentes en el producto.

λGi: tasa de fallo genérica de la i-ésima familia genérica de componentes.

πQi: factor de calidad de la i-ésima familia genérica de componentes.

Ni: cantidad de componentes de la i-ésima familia presentes en el producto.

El MIL-HDBK-217F(N2), no se actualiza desde 1995 y no tiene encuenta, por tanto, las mejoras en fiabilidad logradas en los último 23 años, por lo que tiende a dar una previsión muy pesimista de la tasa de fallos, alejada de la realidad demostrada en el uso en campo. Además, penaliza los componentes estándar comerciales con un multiplicador de hasta 1.000 veces la tasa de fallo. Para ajustar más la predicción a la realidad es conveniente realizar los ajustes previstos en la norma ANSI VITA 51.1, subsidiaria del MIL-HDBK-217F(N2) [4]

Por tanto, el primer paso es definir un diseño de alto nivel del driver objeto del programa de fiabilidad. El equipo de diseño, con arreglo a su experiencia y a diseños anteriores, estimará la cantidad de componentes de cada una de las familias genéricas: Microcircuitos, Semiconductores Discretos, Resistencias, Condensadores , Inductivos y Varios (bornes, PCB, fusibles, etc) que compondrán cada bloque. Con estos datos, entrando en las tablas del MIL-HDBK-217, se obtiene una primera predicción de la tasa de fallo del de λdriver = 1,294 fallos por millón de horas de funcionamiento, lo que supone una tasa del 0,1294% cada 1.000 horas y un MTTF de 772.797 horas. Esto supone que la fiabilidad prevista para una vida útil de 100.000 horas, es del 88%. Es decir, el 88% de la población alcanzaría las 100.000 horas de vida útil, o lo que es lo mismo, la probabilidad de que un equipo sobreviva 100.000 horas es del 88%.

También se obtiene una distribución por familias genéricas de componentes, que servirán como referencia para las tareas de diseño. Por ejemplo, se objserva que la familia genérica de microcircuitos (microprocesadores, memorias, microcircuitos lineales, etc) que supone un 3% de los componentes previstos, tienen una contribución a la tasa de fallo prevista del 41,3%. Por tanto, una inversión en mejor fiabilidad de los mismos debería valorarse.

Así mismo, la distribución por bloques indica que hay margen de mejora de fiabilidad durante el diseño sobre todo en el bloque controlador y en el de regulación.

ASIGNACIÓN DE OBJETIVOS DE FIABILIDAD

Con los datos de la previsión inicial de la tasa de fallos y su distribución por familias de componentes y por bloques funcionales, se puede asignar un objetivo de fiabilidad prevista para el driver una vez diseñado. Y esa tasa total de fallo del sistema, se repartirá entre los distintos bloques funcionales del diseño. Se orienta así a los ingenieros de desarrollo sobre los puntos críticos que deben trabajar para alcanzar los objetivos de fiabilidad propuestos.

En el caso estudiado, se fijó un objetivo de 0,7 fallos cada 106 horas (MTTF: 1,43x106 horas), o una tasa de fallo de 0,07% cada 1.000 horas. Por tanto, se pretende que la probabilidad de que una unidad determinada del driver siga funcionando al alcanzar la vida útil estimada de 100.000 horas sea R(t) = 93,24%

Hay muchas alternativas a la hora de asignar objetivos de fiabilidad en esta fase inicial del diseño. Puede repartirse equitativamente entre todos los bloques (técnica de asignación equitativa). Pueden asignarse coeficientes a cada bloque en función del estado del arte, de la complejidad de cada bloque, de las condiciones ambientales, etc (técnica de factibilidad de los objetivos).

En este caso se empleó el método de asignación de objetivos conocido como “algoritmo de minimización del esfuerzo”, que pretende minimizar el esfuerzo neceario para alcanzar el objetivo de fiabilidad asignado. El método asume que la fiabilidad de cada bloque funcional se ha predicho y que se demandarán mejoras mayores de los bloques con menor fiabilidad prevista incialmente. En la fig. 8 se muestran los objetivos de fiabilidad propuestos a los diseñadores para cada uno de los bloques. La mejora global propuesta fue del 42% con respecto a la predicción inicial.

TÉCNICAS DE DISEÑO PARA LA FIABILIDAD

Las técnicas de diseño para la fiabilidad se emplean para conseguir que los objetivos de fiabilidad se alcancen en el producto final. En el proyecto del driver de corriente constante para iluminación exterior de tecnología LED objeto de este estudio, se emplearon las siguientes:

a.- Gestión de proveedores y componentes. Es muy importante la selección de proveedores y componentes que cuenten con históricos de fiabilidad y realicen test de screening. Un alto volumen y continuidad de la producción es recomendable, puesto que la capacidad de fabricar componentes sin defectos está directamente relacionada con aquéllos. El motivo es que el ciclo de mejora es más corto, porque los fallos se producen antes y se analizan con mayor frecuencia, permitiendo un crecimiento de la fiabilidad más rápido.

b.- Derating. Se define como hacer trabajar a un componente sometido a solicitaciones (stress) inferiores a los nominales. Puede conseguirse reduciendo la solicitación o aumentando la resistencia del componente. Es eficaz porque la tasa de fallos tiende a decrecer a medida que se reducen el nivel de solicitación aplicado al equipo. La fiabilidad de los componentes electrónicos es función de las solicitaciones eléctricas y térmicas. Una solicitación térmica más alta, implica generalmente una mayor temperatura de la unión que incrementa la actividad química del componente, tal y como expresa el modelo de Arrhenius,resultando en una tasa de fallo mayor.

c.- Análisis de las tolerancias del circuito. Con el envejecimiento y el stress, los valores de los parámetros físicos y eléctricos de los componentes tienden a experimentar variaciones que, si no se tienen en cuenta durante el diseño, pueden degradar el rendimiento del circuito y ser una causa significativa de fallo. También deben tomerse en consideración las variaciones en los parámetros electricos de los componentes que tienen su origen en la variabilidad del proceso de fabricación. El diseñador procurará conseguir el mayor nivel de insensibilidad del sistema a dichas variaciones.

d.- Análisis de Modos de Fallo y sus Efectos (AMFE). El Análisis de Modos de Fallos de Diseño y sus Efectos es una técnica analítica y sistemática que evalúa la probabilidad de fallos y los efectos de los mismos Es una herramienta proactiva de la que se obtienen medidas preventivas de los posibles fallos.

e.- Diseño para la fabricabilidad y el montaje. Es un proceso de ingeniería concurrente que pretende optimizar la relación entre la función de diseño, la fabricabilidad y la facilidad de montaje. Se reduce así la introducción de defectos patentes y latentes durante la fabricación del driver.

PREDICCIÓN FINAL DE LA FIABILIDAD – PREDICCIÓN INTRÍNSECA

Terminada la fase de diseño, la lista de materiales estará completa y a disposición del ingeniero de fiabilidad. Fabricados los primeros prototipos, dispondrá ya de las solicitaciones eléctricas, térmicas y mecánicas a las que están sometidos los componentes. Puede entoces proceder a calcular una predicción de fiabilidad con mayor detalle. Para ello empleará el modelo, que, a pesar de estar concebido para aplicaciones militares, y no actualizarse desde 1995, sigue siendo el más empleado en la industria electrónica: el de análisis de las solicitaciones de los componentes o “Part Stress Analysis” desarrollado en el MIL-HDBK-217F(N2). El método asocia a cada familia genérica de componetes una tasa de fallo básica que se modifica multiplicando por unos coeficientes que representan los factores que afectan a la fiabilidad (figura 9):

Así, por ejemplo, para un condensador cerámico la tasa de fallo se calcula como:

donde:

πT : Factor de aceleración debido a la temperatura.

πC : Factor de capacidad.

πV : Factor de stress de tensión.

πQ : Factor de calidad que depende de las normas militares aplicadas.

πE : Factor de ambiente de funcionamiento (terrestre, embarcado, aéreo,...).

Y para dispositivo bipolar monolítico, la tasa de fallo intrínseca se calcula como:

donde:

πL : Factor de madurez tecnológica de la familia genérica.

πQ : Factor de calidad que depende de las normas militares aplicadas.

πT : Factor de aceleración debido a la temperatura.

πV : Factor de stress de tensión.

πE : Factor de ambiente de funcionamiento (terrestre, embarcado, aéreo,...).

C1: Factor de complejidad del microcircuito.

C2: factor de complejidad de la envolvente.

En el caso estudiado del driver para alumbrado público de tecnología LED , se fijó un objetivo de 0,7 fallos cada 106 horas (MTTF: 1,43x106 horas), o una tasa de fallo de 0,07% cada 1.000 horas. Tras el proceso de diseño y desarrollo realizado teniendo encuenta los conceptos de ingeniería de fiabilidad, se obtuvieron los resultados de la fig.9. Se mejoró el objetivo en un 1,3%.

Obtenido el dato de fiabilidad prevista de un MTTF de 1.748.557 horas (203 años), es interesante considerar que no debe pensarse que este es el tiempo que debe esperarse que debe sobrevivir un producto una vez instalado. Es decir, no es la vida útil estimada, ni la vida esperable en al menos el 50% de los equipos instalados.

El MIL-HDBK-217-F(N2):

- Calcula una fiabilidad intrínseca, por lo que no tiene en cuenta, ni las causas de fallo que introduce el proceso productivo, ni las que introducen las condiciones de instalación.

- No tiene encuenta ni los fallos de mortalidad infantil, ni los del periodo de desgaste.

- Parte del presupuesto, común en la industria electrónica, de que la distribución de probabilidad de fallo durante el periodo de vida útil, sigue una ley exponencial en la que la probabilidad de supervivencia hasta un determinado instante de tiempo es:

Es decir que por definición de la distribución exponencial, la probabilidad de supervivencia de un equipo hasta alcanzar su MTTF es del 37%. No debe por tanto confundirse con la vida útil de un equipo.

ENSAYOS DE FILTRADO – ENVIRONMENTAL STRESS SCREENING

Como se ha comentado anteriormente, la fiabilidad inherente es consecuencia del diseño del producto. Sin embargo, sin un programa de aseguramiento de la fiabilidad durante la producción, la fiabilidad inherente al producto puede quedar seriamente degradada por los defectos introducidos por problemas de los componentes o por el proceso de fabricación. Algunos se harán patentes durante las inspecciones, pero otros permanecerán como defectos latentes hasta que una determinada condición de operación precipite el fallo.

Los ensayos de filtrado ambientales (Environmental Stress Screening, ESS), pretenden precipitar aquellos fallos latentes cuyo mecanismo de fallo puede ser acelerado. Los tipos de ESS más habituales son los ciclos de temperatura, las vibraciones aleatorias, las vibraciones senoidales, los ciclos on-off, los burn-in a alta temperatura, etc. Los defectos latentes que pueden ser precipitados por los ESS se indican en la tabla de la fig. 11.

En nuestro caso de estudio el programa empleado incluye ESS térmicos y de vibración. Las condiciones de ensayo seguidadas fueron similares:

- Los drivers se testearon antes del ESS para asegurar que no existían fallos patentes anteriores.

- Los divers se testearon de nuevo, tras terminar el ESS, con las mismas pruebas aplicadas antes del ESS para determinar si se había precipitado algún fallo latente o no.

- Los drivers bajo ESS estaban conectados y la solicitación a la que se sometieron era representativa de las condiciones normales de empleo.

- El ESS está definido por su potencia de filtrado o “Screening Strength” (SS) que es el porcentaje de defectos latentes que es capaz de precipìtar el test.

Los ensayos que se describen a continuación fueron desarrollados en el RADC (Rome Air Develpment Center) en su “Stress Screening of Electronic Hardware” [10] y “Environmental Stress Screening” [11]. En estas referencias se puede consultar como se derivaron las fórmulas de la potencia de filtrado del test (SS) que se emplearón en los test descritos a continuación.

a.- Ensayo ESS de vibración a una sola frecuencia. La potencia de filtrado es función del nivel de aceleración en nº de “g”. Se ensayó a 0,03G. También es función de la duración del test en minutos. Se ensayó durante 10.140 minutos. La muestra bajo ensayo fue de 40 unidades y no se precipitó ningún defecto. La potencia de screening (SS) calculada indica que se precipitan el 99,07% de los defectos latentes. Por tanto, el nivel de defecto latente en la producción, precipitable con este método, será inferior al 0,13%.

b.- Ensayo ESS a temperatura constante. En este ensayo, la potencia de filtrado depende de la diferencia entre la temperatura del ensayo y 25ºC, que en este cao fue de 17ºC ya que se ensayó a una temperatura de 42ºC. La duración del test fue de 1.440 horas. Se ensayaron 40 unidades y no se precipitó ningún defecto, cuando la potencia de screening(SS) debe detectar el 99,999% de los defectos latentes. Por tanto, el nivel de defecto latente será inferior al 0,001%

El programa ESS proporciona así una razonable seguridad de que la tasa de defectos latentes introducidos por los propios componentes o por el proceso de fabricación del equipo es suficientemente pequeña como para no comprometer el objetivo de fiabilidad en campo.

DEMOSTRACIÓN DE LA FIABILIDAD

a.- Antes del lanzamiento. La larga vida útil exigida actualmente a los equipos electrónicos, hace inviable la aplicación de la inspección de la fiabilidad por muestreo a todos los lotes, debido a que la duración de los ensayos que se requerirían para demostrar la fiabilidad, superan los plazos comerciales razonables. Sin embargo, sigue siendo necesaria la demostración de la fiabilidad al menos en la pre-serie industrial. Para ello pueden emplearse las tablas muestreo contenidas en el MIL-HDBK-108 [12]. Para un driver con una vida útil de 100.000 horas, un posible plan de demostración de la fiabilidad sería:

- Duración disponible para el ensayo: 5.000 horas

- Vida media aceptable: 100.000 horas

- Vida media inaceptable: 33.333 horas

- Riesgo del fabricante α: 0,10 (si la vida media es mayor de 100.000 horas se rechazará con una probabilidad del 10%)

- Riesgo del comprador β: 0,10 (si la vida media es menor de 33.333 horas, se aceptará con una probabilidad del 10%

- Nº de muestras a ensayar: 63 unidades

- Nº de rechazo: 6 (si fallan menos de 6, se aceptará la preserie, como fue el caso tras 1 fallo registrado)

b.- Seguimiento en campo

Una vez comienza la comercialización del equipo, los datos sobre horas de funcionamiento y fallos registrados en campo deben monitorizarse y ofrecen al ingeniero de fiabilidad mayor cantidad de datos con los que calcular un intervalo de confianza para el MTTF del equipo en condiciones reales. La ecuación para el intervalo de confianza se calcula estadísticamente como función del tiempo de ensayo, del nivel de significación del test que se quiera alcanzar y del número de fallos que se produzcan durante el tiempo de test.

Para nuestro caso de estudio, actualmente, el tiempo acumulado de funcionamiento de los equipos en campo es de T = 1.125.367 horas, habiéndose detectado 1 fallo. Por tanto, en estos momentos, el estimador puntual del MTTF es de 1.125.367 horas con una probabilidad de supervivencia a las 100.000 del 92%. El intervalo de confianza para el verdadero valor del MTTF es de (234.351 , ∞) horas, con un nivel de confianza del 90%.

La monitorización frecuente de este intervalo junto con el análisis exhaustivo de las unidades devueltas de campo, permite detectar si el nivel de fiabilidad se degrada y aplicar las acciones correctivas necesarias para corregirlo si fuera necesario.

CONCLUSIONES

El diseño y aplicación de un programa de ingeniería de fiabilidad es un requisito indispensable en todo proceso de desarrollo, pues permite incrementar la satisfacción de los usuarios, garantizando altos niveles de disponibilidad y confiabilidad de los equipos y sistemas de alumbrado público. Permite establecer una estrategia de mantenimiento preventivo eficiente y proporciona una base sólida para el cálculo de las garantías de producto ofrecidas.

Juan José González Uzábal

Responsable de Calidad y Director Industrial ELT